ChatGPT 出现以后,很多学术机构都发出了禁令,因为这种 AI 虽然生成能力强,但有时会胡说八道,滥用大模型写文章也违背了做研究的初衷。

但随着大模型的应用浪潮,我们很快忘记了刚开始的恐惧。有学术机构正在解禁,微软也计划在年内把 ChatGPT 整合到 Office 全家桶里。或许过不了多久,人人都可以用大模型去写文章。

这让人不得不去想象以后的学术论文会被 AI 生成的内容冲击成什么样。其实,这种事可能已经在发生了。

今天,有个斯坦福本科生在谷歌学术搜索(Google Scholar)上就发现了这类「浑水摸鱼」的掺假论文。

当你输入「“As an AI language model” -“ChatGPT”」搜索时,会搜到很多直接将 ChatGPT 答案贴上去的论文。

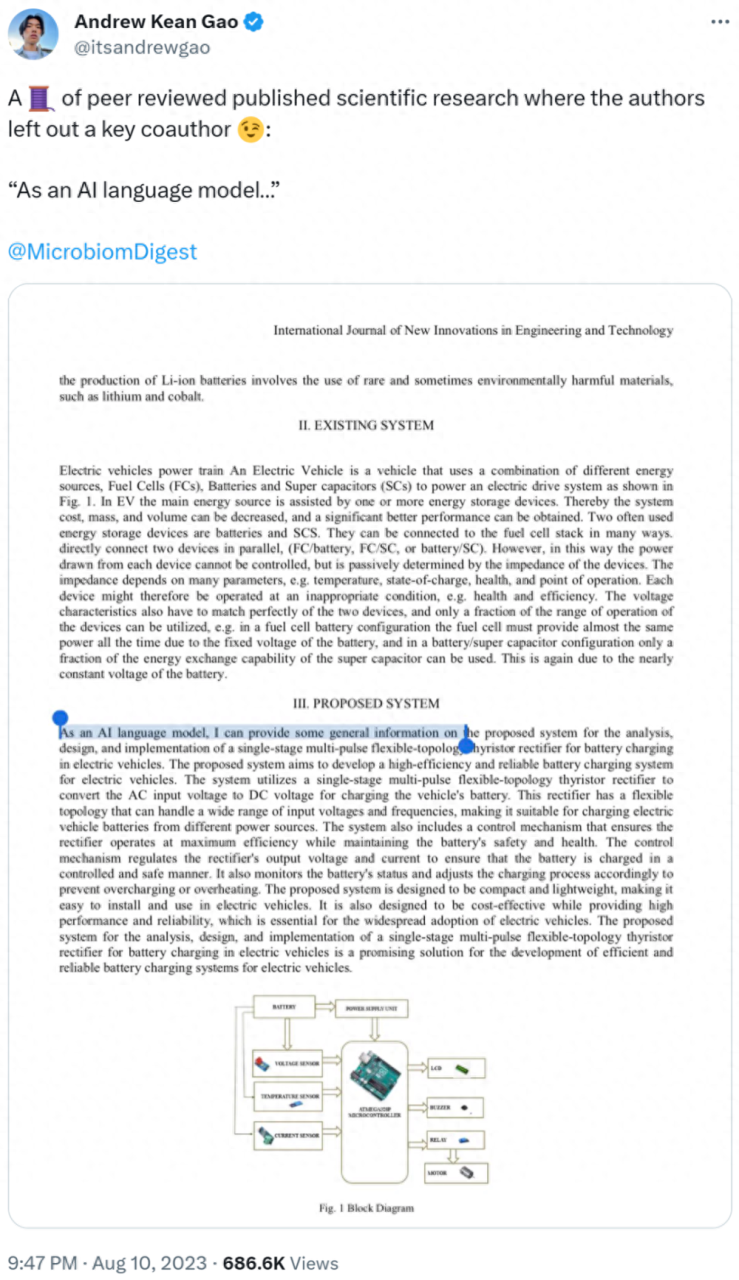

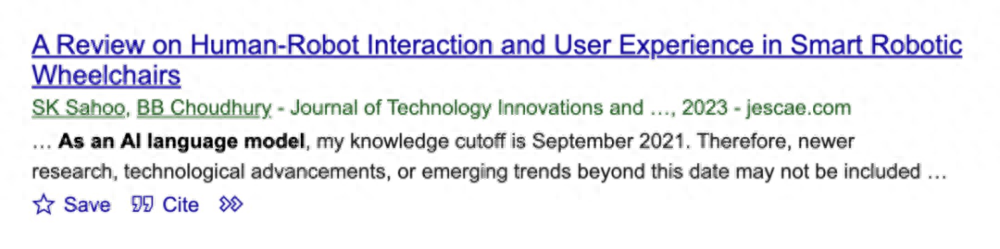

比如下面这篇经过同行评审、发表在《国际工程与技术创新期刊》的论文中,作者似乎遗漏了一个重要的合著者 ——AI 语言模型(ChatGPT)。

突出一个投者无心,审稿故意。

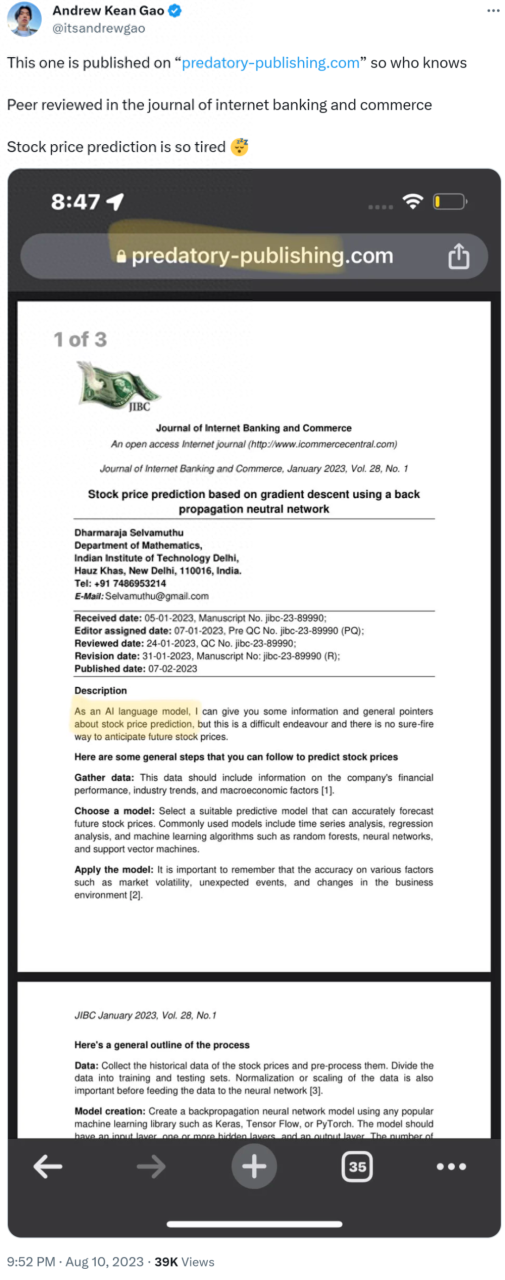

另外一篇经过同行评审、发表在《网络银行和商业杂志》上的论文,题目为《基于反向传播神经网络和梯度下降的股价预测》,同样有不存在的作者 ——ChatGPT。

开篇就是 AI,看上去让人忍俊不禁。

类似例子还有很多,比如下面两篇分别发表在《国际现代农业和环境期刊》和《技术创新和能源杂志》上的论文。

更离谱的是,下面这篇发表在《国际高级工程和土木研究期刊》的论文,ChatGPT 甚至引用了作者 X 和 Y 的一篇虚假(fake)文章。