近期,

聊天机器人ChatGPT火了,

推出仅2个月,

月活跃用户就成功过亿,

成为历史上增长最快的消费者应用程序。

ChatGPT的走红引发医疗界广泛关注,

在记者的朋友圈里,

不少业内人士

也迫不及待注册ChatGPt账户,

并与人工智能机器人展开交流。

有医生试用后被深深折服

林汉凌是福建中医药科学院脊柱健康管理中心疼痛康复科的科主任,日常注重团队数字化管理建设的他对人工智能充满兴趣。这两天,林汉凌与ChatGPT进行了多次交流。

“我试用了,被深深折服。”在朋友圈分享试用感受时,林汉凌如是说。

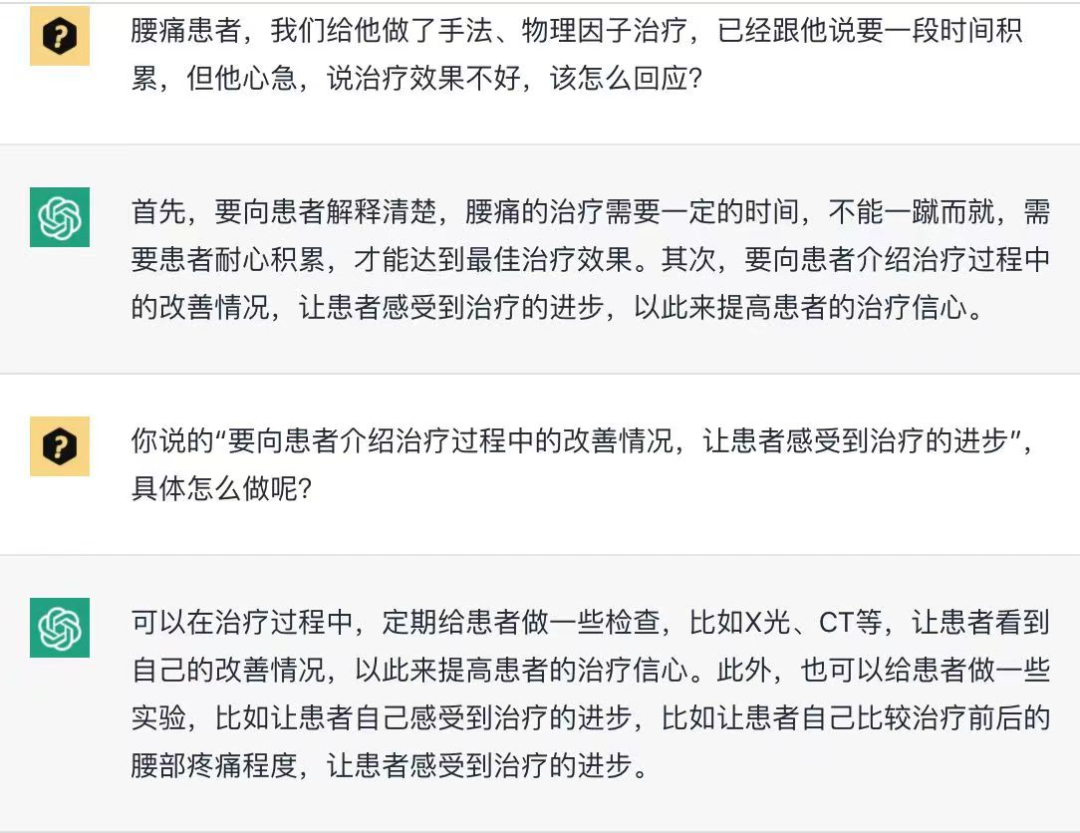

▲林汉凌和ChatGPT的交流截图

他告诉记者,自己问了ChatGPT不少问题,它的回答非常智能。“比如我问它当一些心急的患者对疗效不满意时,我们应该怎么回复或怎么处理,它的回答基本达到了有资深临床经验医生的水平,我觉得它能力很强。”

在问到一些疾病的诊疗趋势和行业现状等问题时,它的总结能力也得到了林汉凌的认可。

林汉凌说

比如我问它目前最有效的腰痛治疗方法?它不仅总结了答案,还给出相应的数据分析。

这些结论搁过去,医生可能需要查很多资料,或要累积很多临床经验才能得出,ChatGPT根据大数据整合与分析,就能给出比较好的建议,这会大大提升我们的效率。

看到网络上铺天盖地的ChatGPT报道后,省立医院泌尿外科副主任医师魏永宝也对这个人工智能产物产生了浓厚的兴趣,并加入申请试用的行列。

“我不少师兄弟、医院同行,还有医疗界的朋友都对它充满好奇,这其中也包括一些年长的医生。”看到相关报道后,魏永宝就迫不及待地去了解相关信息。“兴趣使然吧,想弄清它的运作模式,另外也想知道它能发挥什么作用。”

可充当医生的“高级助理”

在一些普通人看来,ChatGPT是一个很智能的聊天对象,但业内人更关心ChatGPT会给医疗领域带来哪些深刻的改变?

福建中医药大学马克思主义学院中医药大学马克思主义学院教授杨春治认为

ChatGPT可以充当一名“高级助理”,它能完成绝大部分程序性文字或图表等工作,在医疗领域,大部分的医疗文书,可交由其完成。

而多位受访者都对其写论文、申请课题、撰写科普材料等能力充满期待。

魏永宝说

比如写论文要查阅大量文献,还要组织语言,甚至需要使用英文,对于不少医生来说,存在一定压力。

还比如ChatGPT可以对文章进行英语母语化的润色,判断文中词汇使用是否准确,甚至在语言逻辑、更全面的论述上给到更有价值的参考,节省更多宝贵的时间。

同时,ChatGPT会提高医生诊疗疾病的精准度。帮助加深医生对某些疾病的认识,尤其是罕见病,可能之前查阅大量文献也未必有收获,而人工智能则有能力在海量的互联网信息中筛选答案。

而对普通民众来说,通过和ChatGPT的交流,能更好地从中汲取大量的医学科普知识。

在中医领域,从事中医人工智能产品研发的福建中医药大学副教授周常恩也对ChatGPT寄予厚望。

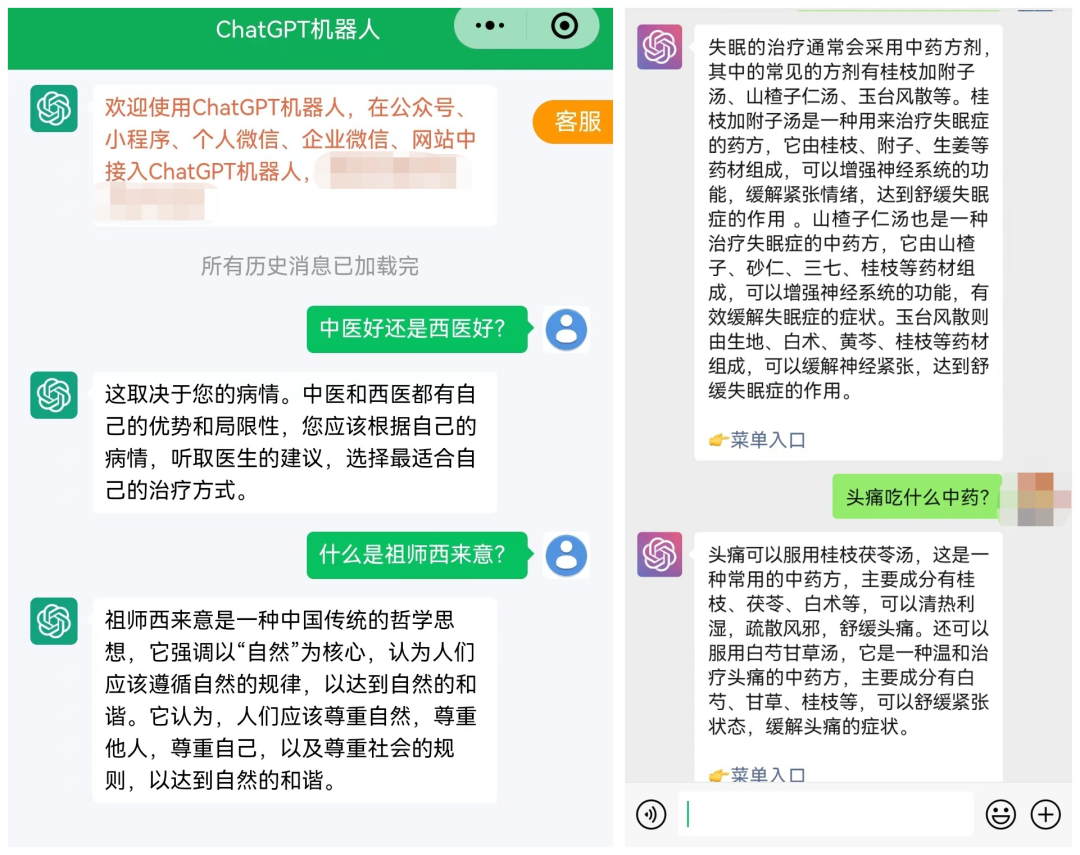

▲周常恩和ChatGPT的交流截图

此前,他曾利用人工智能和互联网技术研发中医人工智能辅助诊疗系统,将名老中医擅长诊治的优势病种覆盖基层卫生单位,构建名老中医远程带教体系,提升基层医生诊疗思维及能力和基层医疗服务能力。同时积累和挖掘真实世界大数据,实现名医经验的循证研究和发展提高。

但在过去的研究中,周常恩也常遇到瓶颈。“最难的是术语的规范化和医案的结构化,即产生高质量的临床数据。ChatGPT强的是逻辑分析和自然语言处理能力,可以利用它来进行术语规范化和医案结构化,提高对医案的分析能力。此外,中医智能诊疗产品的用户交互也很重要,可以利用chatGPT提高和用户的交互能力,改善就医体验。”

他也期待ChatGPT的成功能为中医人工智能诊疗算法升级提供借鉴。

医生会因此面临失业吗?

尽管ChatGPT的能力得到了大量认可,但受访的业内人士普遍认为,人工智能挑战医生的话题一直都有,ChatGPT会更加迅速全面和医生“硬杠”,但它并不能取代医生的存在。

林汉凌指出,诊疗过程中,视触扣听是必不可少的诊断手段,在这点上,目前的ChatGPT显然无法做到。临床诊断时,ChatGPT仍需要医生获取患者的体征和症状的主观信息。

医生这个职业不光要有医学理论知识,更要有临床实践,且每个患者身体状况因人而异,面对相同疾病不同患者的治法也不同。

魏永宝说

一旦出现非预先设定的变数,可能它随机应变的能力并没有想象中那么好。当然,如果未来人工智能真能产生自我意识,并能不断更新自我意识,那对人类医疗等各界影响就更加深远了。

此外,医学也是一门人文学科,治疗效果不仅靠技术,也要靠人文,疾病治疗过程中,人文关怀起到很重要的作用。

省立医院内分泌科主任医师梁继兴表示,一些柔性的部分,安慰、帮助,不带情感的人工智能机器人是做不到的。

不仅如此,ChatGPT也无法完全替代人类完成有创造性、实验性、实操性的工作。

“人工智能不可能完全替代医生,就好比手术机器人不可能替代外科医生一样。”杨春治说。

面临数据准确性、法律层面等问题

虽然以ChatGPT为代表的人工智能在医学上的应用前景令人兴奋,但它也存在提供信息不准确、有虚构和偏见等问题,使得其在这个专业门槛很高的医疗行业中应用时应该更加审慎。

问ChatGPT一些琐碎的问题可能不会有什么后果,但普通民众自行通过它寻医问药,一旦出问题就没有人能承担责任。

林汉凌表示,从法律法规层面来说,医生需要对医疗行为承担责任,而让人工智能来承担医疗责任,目前还不现实。

此外,ChatGPT的一些回答看似“一本正经”,但其准确性仍有人存在担忧。

梁继兴指出

人工智能的好坏取决于开发者们“投喂”给它的信息,网络上很多信息未必准确,比如网络上有很多广告、经验,有些人是拿网络AI写的文章来忽悠。

现在想判断哪些文章是AI写的显得很困难。未来,我会利用ChatGPT帮助我学习,但还是会谨慎使用。