【新智元导读】搅动了百亿美金市场的ChatGPT,再一次证明了:AIGC,将在2023年给我们的生活带来革命性的剧变。

这几天,「微软砸下百亿美金注资OpenAI」的消息疯狂刷屏。

作为一家没有商业模式的公司,OpenAI怎么就能估值百亿美金?投资人这么好忽悠吗?

其实,拉出OpenAI背后的ChatGPT,大家就多少能明白一点了。这个语言模型「顶流」,最近可谓是无人不知,无人不晓。

而近水楼台先得月的微软,已经悄咪咪地在互联网巨头混战中,先下了一城。

前脚刚表示ChatGPT即将整合进自家搜索引擎必应,后脚就放出ChatGPT计划加入Office「办公全家桶」这个重磅炸弹。

AIGC革命,又到了拼算力的环节

2022年,是AIGC的革命元年。

DALL·E 2的诞生让「文生图」火了整整一年,紧跟其后的Stable Diffussion、Midjourney更是启发了无数人的艺术灵感,甚至让不少画手感到了「失业危机」。

到了年末,ChatGPT更是在全民中掀起AIGC的风暴。虽然是压轴出场,但「强化学习」(RLHF)赋予它的魔力,成功地掀起了一场全民的狂欢。

刚刚我们提到的这些应用,虽然看起来花里胡哨,但在背后提供支撑的依然是大家熟知的大模型们。

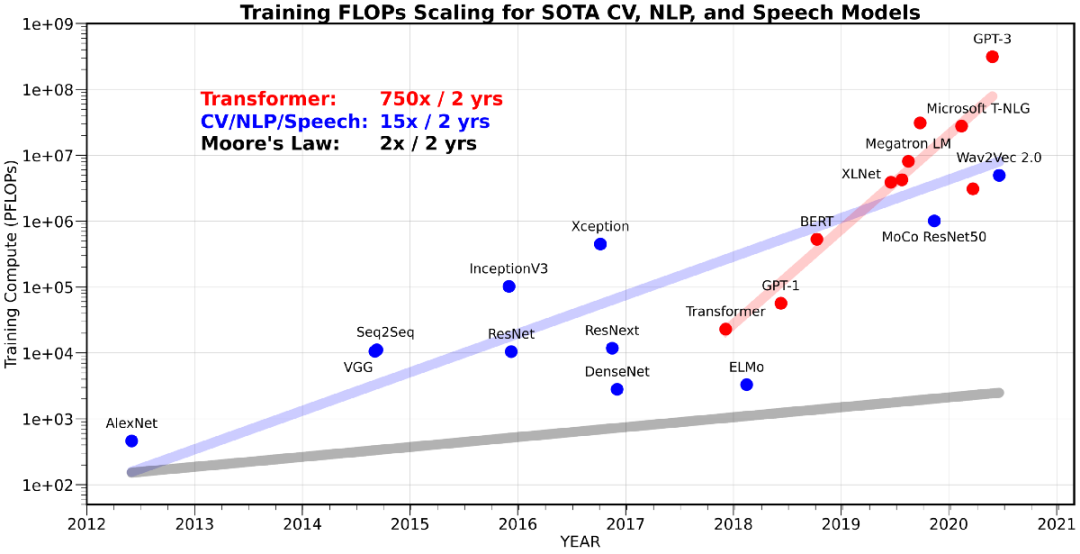

众所周知,对于大模型来说,不管是前期的训练还是后期的推理,都离不开巨量的「算力」。

举个例子,「当红炸子鸡」ChatGPT和DALL·E 2基于的GPT-3,以及国产自研的源1.0、悟道和文心等等,不仅在参数量上达到了千亿级别,而且数据集规模也高达TB级别。

想要搞定这些「庞然大物」的训练,就至少需要投入超过1000PetaFlop/s-day(PD)的计算资源。

也难怪OpenAI在大炼GPT-3之前,会让微软花10亿美元给自己独家定制了一台当时全世界排名前五的超级计算机。

但是问题在于,并不是每个需要到大量AI算力的企业或高校,都能财大气粗地斥巨资搞一个自己的「人工智能高性能计算中心」。

那么,如果我们换一个思路,让算力变得更加「普适普惠」,是不是也能实现相同或更好的效果呢?

于是,在2020年12月的时候,国家信息中心和浪潮信息联合发布了《智能计算中心规划建设指南》。其中,便提到了一个全新的概念——智能计算中心(简称,智算中心)。

智算中心是什么?

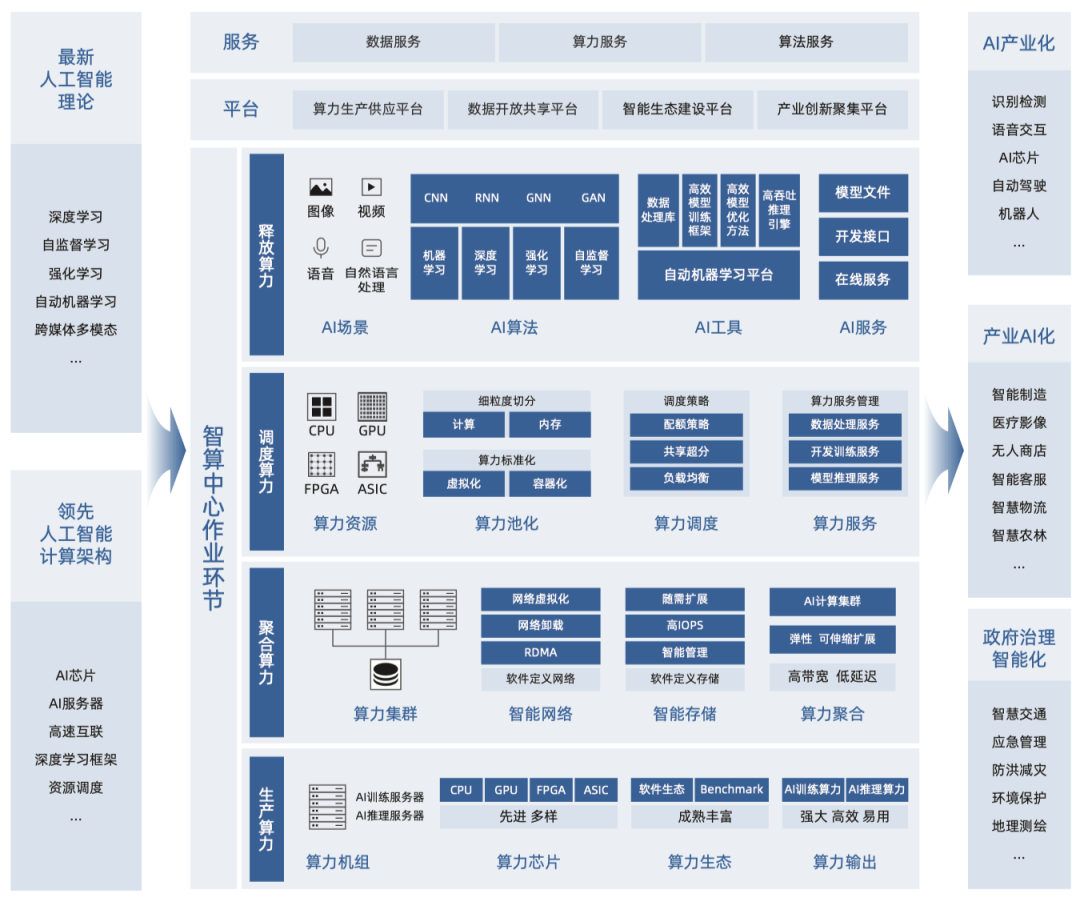

为了能更好地解决人工智能领域的问题,智算中心的发展就需要基于最新的AI论和先进的AI计算架构,并以AI芯片、AI服务器、AI集群为算力的载体。

首先,当前主流的AI加速计算,主要是采用CPU系统搭载GPU、FPGA、ASIC等异构AI加速芯片。

由于GPU芯片中原本为图形计算设计的大量算术逻辑单元(ALU),可为以张量计算为主的深度学习计算提供很好的加速效果,因此广受学术界和工业界的欢迎。

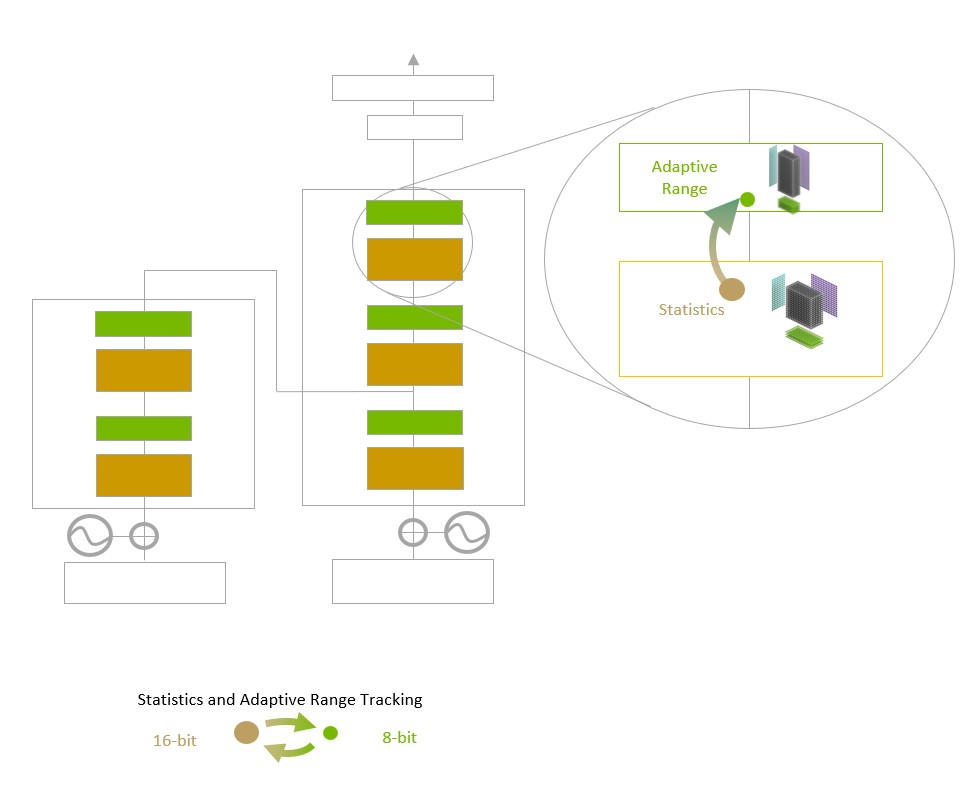

随着越来越深入的应用,GPU芯片本身也根据AI的计算特点,进行了针对性的创新设计,如张量计算单元、TF32/BF16数值精度、Transformer引擎(Transformer Engine)等。

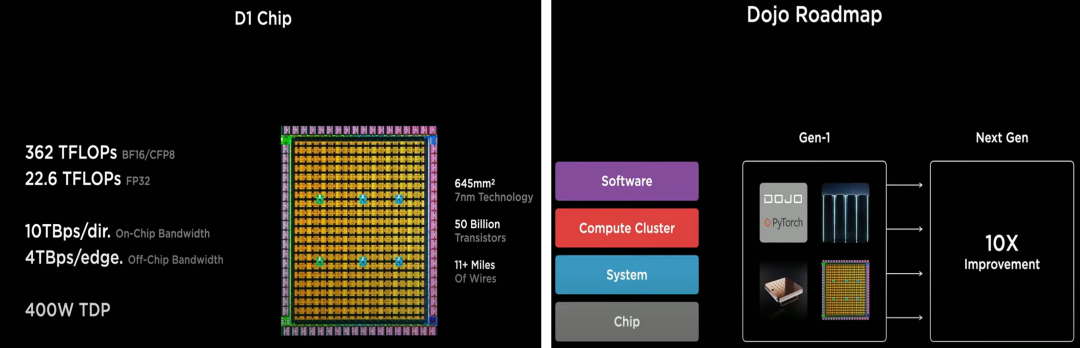

而更加「专一」的AI计算加速芯片,主要脱胎于GPU芯片。

特斯拉Dojo人工智能训练芯片

其次,作为智算中心算力机组的AI服务器,则采用CPU+AI加速芯片的异构架构,通过集成多颗AI加速芯片实现超高计算性能。为了满足各领域场景和复杂的AI模型的计算需求,AI服务器对计算芯片间互联、 扩展性也有着极高要求。

最后,智算中心还需要对业界主流、开源、开放的软件生态提供充分的支持。

比如,用于开发AI算法的深度学习框架TensorFlow和PyTorch,为适应CV、NLP等特定场景开发而构建的一系列开源库等等。

智算中心总体架构

不过,和国外那些大厂给自己定制的高性能计算中心不同,智算中心其实是一个面向公众的基础设施,更好地解决建不起、用不起算力的问题。

其中最为直观的便是,作为「神经中枢」的智算OS(智算中心操作系统)就是为了让智算中心可以对算力资源池进行高效管理和智能调度,从而更好地对外提供算力、数据和算法等服务。

如今,距离2020版《智能计算中心规划建设指南》的发布已经时隔两年,而我国的智算中心发展也已经进入了新阶段。

为此,国家信息中心和浪潮信息联合开展了与时俱进的研究,于2023年1月推出了更新的《智算中心创新发展指南》(以下简称「指南」)。

所以,为何还要兴建智算中心?

智算中心是数字经济时代促进产业转型升级、优化产业结构、提升城市竞争力的关键基础设施,并为快速增长的人工智能算力需求提供了必不可少的支撑。

具体来说可以分为四个方面:

推进AI产业化、赋能产业AI化、助力治理智能化、促进产业集群化。

AI产业化

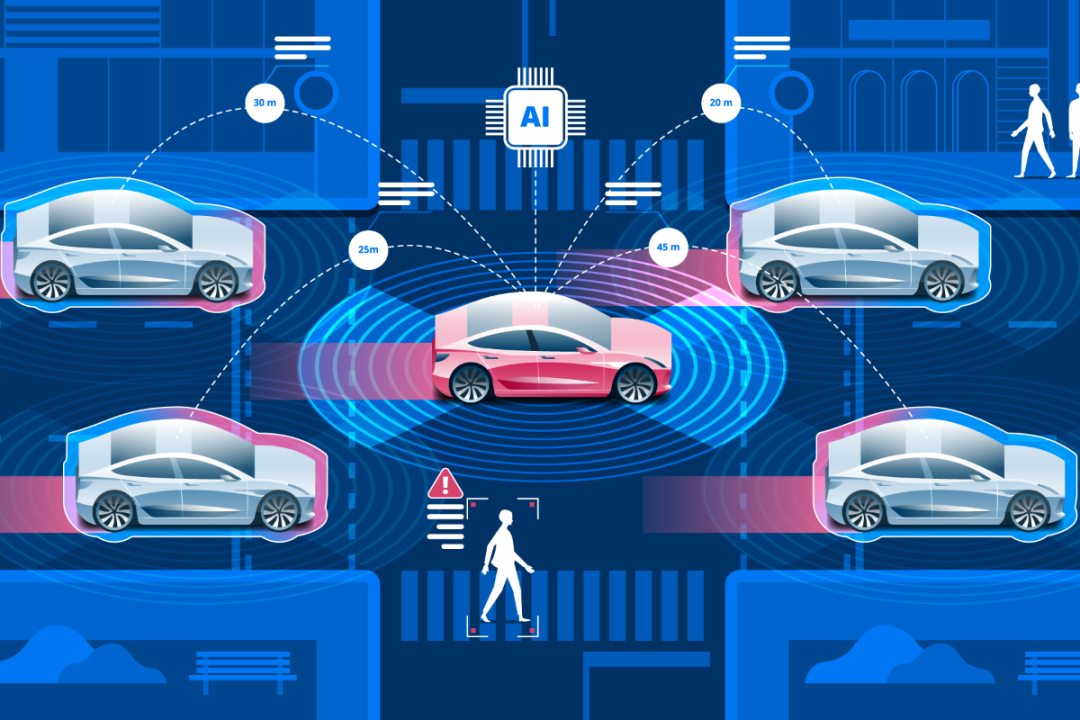

AI产业化的一个重要例子,就是自动驾驶。

在自动驾驶的场景中,需要基于AI技术,让车辆能够像人类驾驶员一样准确识别驾驶环境中的关键信息,并对周围运动单元的潜在轨迹做出预判。

在训练算力消耗上,自动驾驶感所采用的知模型要远大于一般的计算机视觉感知模型。

比如,特斯拉的L2级FSD自动驾驶融合感知模型,训练过程使用了百万量级的道路采集视频,算力投入约为500PD。

而且,随着自动驾驶级别从L2提升到L4,对算力的需求将进一步提高。

对此,智算中心提供的普惠算力,可以极大降低自动驾驶所需算力的成本。

产业AI化

在2022年,有一个概念非常流行,叫「AI for Science」。

这是一种新的科研范式,指科学家们用AI技术作为生产工具。

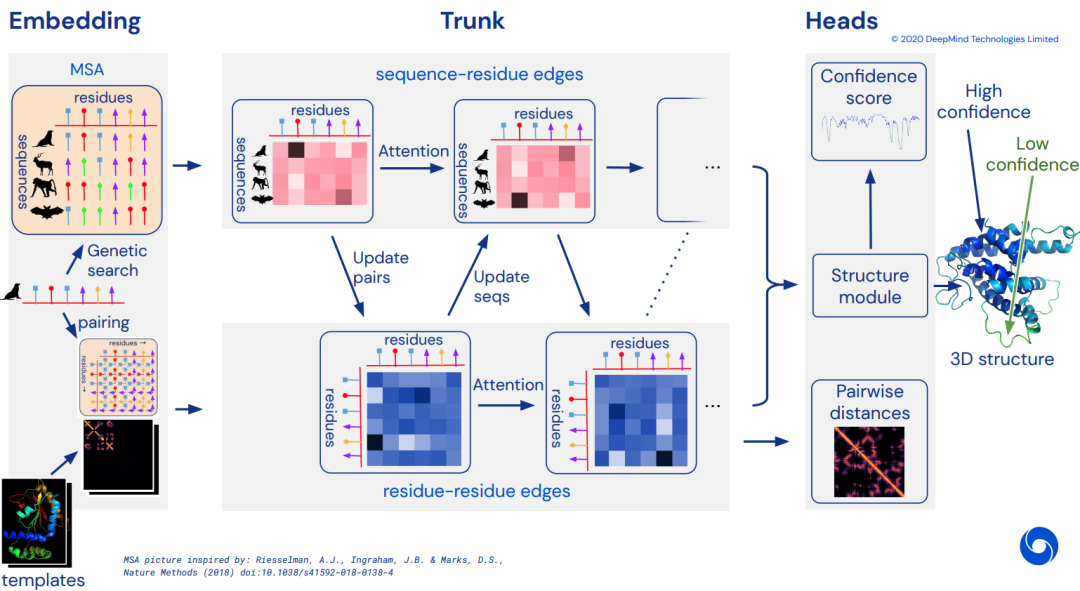

要说今年AI for Science最广为人知的例子之一,就是DeepMind开发的AlphaFold 2了。

截至目前,AlphaFold 2已经可以预测出2亿多个蛋白质结构,几乎覆盖了整个「蛋白质宇宙」。通过AlphaFold 2,单个蛋白结构的预测时间缩短到了分钟级,准确率也达到了92.4%。

AlphaFold 2的开发,就是以巨量算力为支撑的。仅在训练数据准备阶段,AlphaFold 2就消耗了约2亿核时的CPU算力,训练过程中更是消耗了约300PD的AI算力。

而非常契合AI for Science算力需求的智算中心,将成为支撑高校和科研院所高质量科研的重要基础设施。

治理智能化

另外,智算中心还能为城市公共服务和智能化治理,提供智算能力支撑。

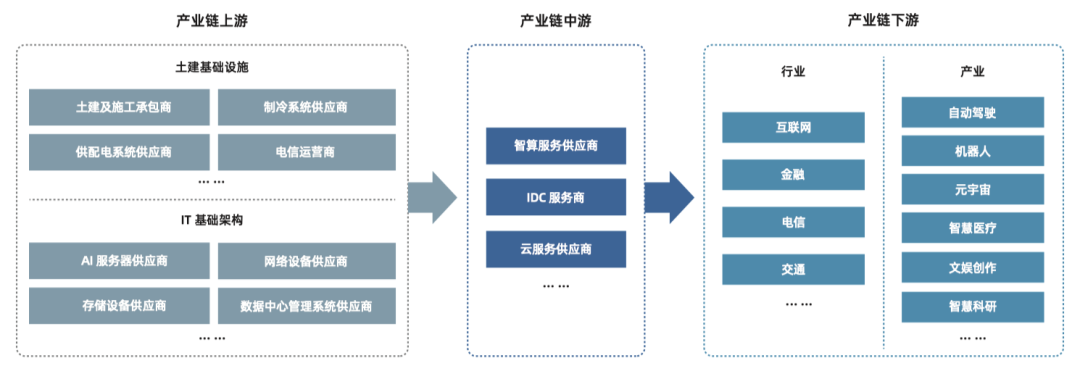

产业集群化

智算中心能够聚合当地人工智能的研发优势、人才优势、产品优势与产业投资,实现产业链协同,促进产业集群化发展。

智算中心产业链

现在,智算中心更是成为提升国际竞争力的关键基础设施。

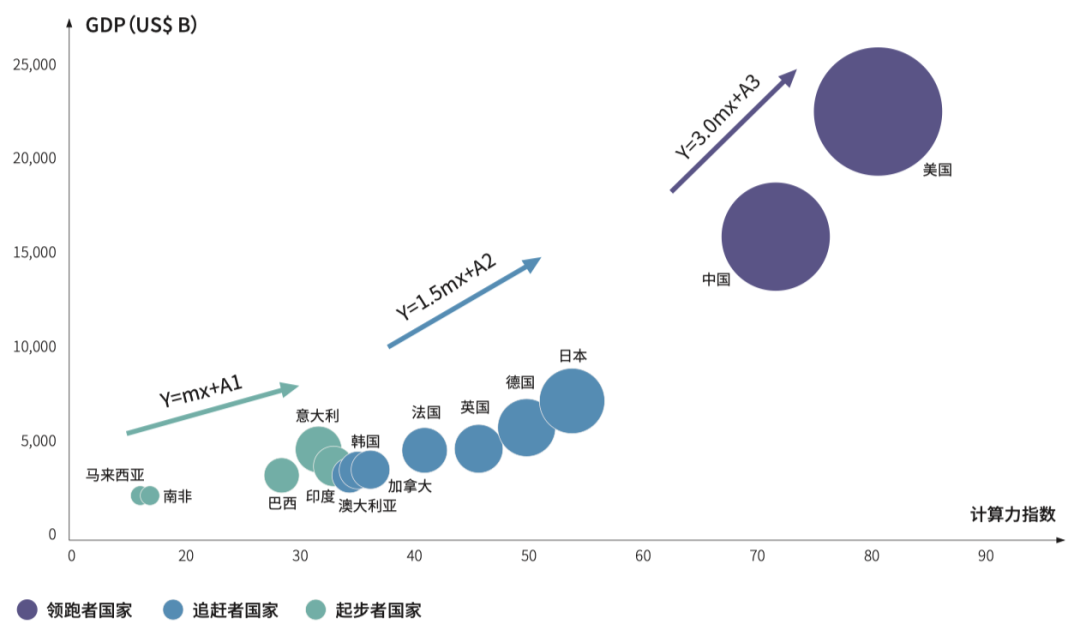

我们都知道,人均GDP指标可以衡量一个国家经济发展,人均算力水平的高低也可以衡量一个国家的智能化水平。

根据《2021-2022全球计算力指数评估报告》,国家计算力指数与GDP的走势呈现出了显著的正相关,计算力指数平均每提高1点,数字经济和GDP将分别增长3.5‰和1.8‰

计算力指数与GDP回归分析趋势

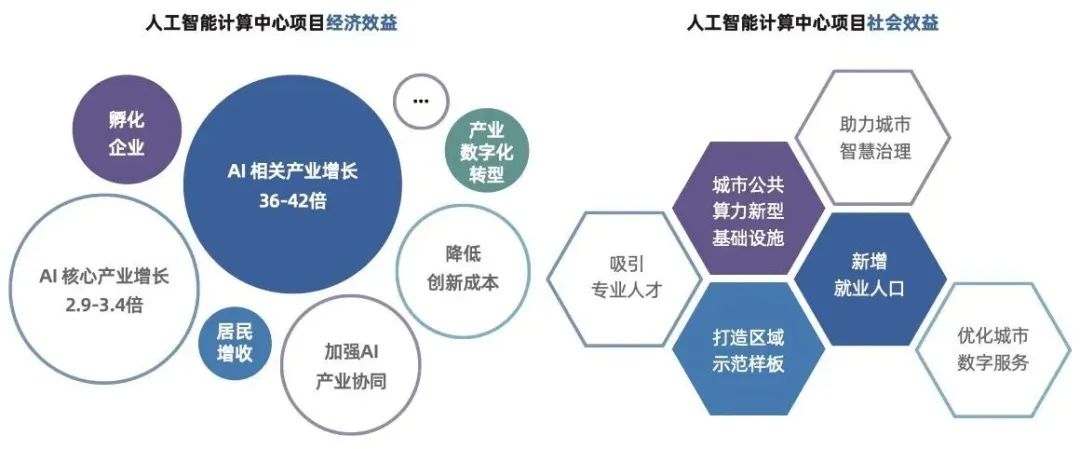

经研究测算,「十四五」期间,在智算中心实现80%应用水平的情况下,城市对智算中心的投资,可带动人工智能核心产业增长约2.9-3.4倍、带动相关产业增长约36-42倍,城市/地区在智算中心建设投入的增长量对创新产出的贡献率约为14%-17%。

不难看出,智算中心对于城市经济发展,已经形成一股不可忽视的力量。

智算中心项目的经济社会效益

基于这些原因,智算中心这个概念一经提出,便引发了建设热潮。据统计,现在全国有超过30个城市正在建设或提出建设智算中心。

然而,问题也随之而来

不可忽视的是,在如火如荼的建设过程中,这些智算中心也暴露出了很多问题和挑战。

首先,我国对智能算力的需求与日俱增。

《2022-2023中国人工智能计算力发展评估报告》数据显示,2021年我国智能算力规模达155.2 EFLOPS(FP16),预计到2026年,我国的智能算力规模将达到1,271.4 EFLOPS。

在未来80%的场景都将基于AI,它们所占据的大部分算力资源,都是由智算中心承载。