【新智元导读】今天,OpenAI发布了具备视觉功能GPT-4 Turbo的正式版,能处理128k上下文。与此同时,GPT-4每3小时40条消息限制似乎也取消了。

趁着谷歌开大会,OpenAI果然又来定向狙击了。

谷歌前脚刚官宣一系列更新,OpenAI立马跟着抛出重大消息——

GPT-4 Turbo迎来「重大升级」!

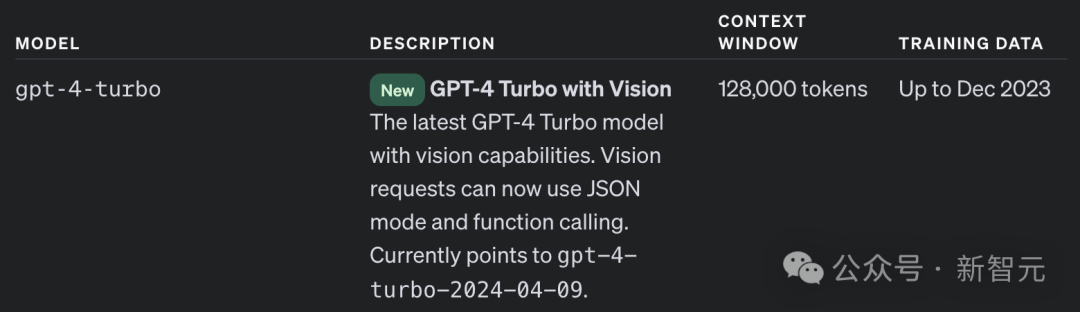

OpenAI今天官宣称,配备视觉能力的GPT-4 Turbo已经可以通过API调用了。

最新模型有128k上下文,训练数据截止到2023年12月。同时,Vision请求也可以使用JSON模式和函数调用。

而现在,早已有开发者用上了最新的模型。

爆火全网的AI工程师Devin就是通过Vision来执行各种编码任务。

Healthifyme团队通过GPT-4 Turbo with Vision构建的应用Snap,可以对各种美食进行拍照识别,为你提供营养洞察。

还有更牛的应用Make Real,直接勾画几笔UI,就能构建出由真实代码支持的网站。

显然,新模型可以有助于简化开发人员的工作流程,创造出更高效的应用程序。